Le langage de programmation Rust

par Steve Klabnik et Carol Nichols, avec la participation de la Communauté Rust

Cette version du document suppose que vous utilisez Rust 1.58 (publié le 13/01/2022) ou ultérieur. Voir la section “Installation” du chapitre 1 pour installer ou mettre à jour Rust.

Le format HTML de la version anglaise est disponible en ligne à l'adresse

https://doc.rust-lang.org/stable/book/

et en hors-ligne avec l'installation de Rust qui a été effectuée avec rustup ;

vous pouvez lancer rustup docs --book pour l'ouvrir.

Vous avez aussi à votre disposition quelques traductions entretenues par la communauté.

La version anglaise de ce livre est disponible au format papier et e-book chez No Starch Press.

Avant-propos

Cela n'a pas toujours été aussi évident, mais le langage de programmation Rust apporte avant tout plus de puissance : peu importe le type de code que vous écrivez en ce moment, Rust vous permet d'aller plus loin et de programmer en toute confiance dans une plus grande diversité de domaines qu'auparavant.

Prenez par exemple la gestion des éléments au “niveau système” qui traite de détails bas niveau de gestion de mémoire, de modèles de données et de concurrence. Traditionnellement, ce domaine de la programmation est jugé ésotérique, compréhensible uniquement par une poignée de personnes qui ont consacré des années d'apprentissage à en déjouer les pièges infâmes. Et même ceux qui travaillent dans ce domaine le font avec beaucoup de prudence, de crainte que leur code ne puisse conduire à des problèmes de sécurité, des plantages ou des corruptions de mémoire.

Rust fait tomber ces obstacles en éliminant les vieux pièges et en apportant un ensemble d'outils soignés et conviviaux pour vous aider sur votre chemin. Les développeurs qui ont besoin de "se plonger" dans le contrôle de plus bas niveau peuvent ainsi le faire avec Rust, sans prendre le risque habituel de plantages ou de failles de sécurité, et sans avoir à apprendre les subtilités d'un enchevêtrement d'outils capricieux. Encore mieux, le langage est conçu pour vous guider naturellement vers un code fiable et efficace en termes de rapidité d'exécution et d'utilisation de la mémoire.

Les développeurs qui travaillent déjà avec du code bas niveau peuvent utiliser Rust pour accroître leurs ambitions. Par exemple, introduire du parallélisme en Rust est une opération à faible risque : le compilateur va détecter les erreurs classiques pour vous. Et vous pourrez vous lancer dans des améliorations plus agressives de votre code avec la certitude que vous n'introduirez pas accidentellement des causes de plantage ou des vulnérabilités.

Mais Rust n'est pas cantonné à la programmation de bas niveau. C'est un langage suffisamment expressif et ergonomique pour rendre les applications en ligne de commande, les serveurs web et bien d'autres types de code agréables à écrire — vous trouverez plus tard des exemples simples de ces types de programmes dans ce livre. Travailler avec Rust vous permet d'acquérir des compétences qui sont transposables d'un domaine à un autre ; vous pouvez apprendre Rust en écrivant une application web, puis appliquer les mêmes notions pour les utiliser avec votre Raspberry Pi.

Ce livre exploite pleinement le potentiel de Rust pour permettre à ses utilisateurs de se perfectionner. C'est une documentation conviviale et accessible destinée à améliorer vos connaissances en Rust, mais aussi à améliorer vos capacités et votre assurance en tant que développeur en général. Alors foncez, préparez-vous à apprendre, et bienvenue dans la communauté Rust !

— Nicholas Matsakis et Aaron Turon

Introduction

Note : la version anglaise de ce livre est disponible au format papier et ebook chez No Starch Press à cette adresse : The Rust Programming Language

Bienvenue sur Le langage de programmation Rust, un livre d'initiation à Rust. Le langage de programmation Rust vous aide à écrire plus rapidement des logiciels plus fiables. L'ergonomie de haut-niveau et la maîtrise de bas-niveau sont souvent en opposition dans la conception des langages de programmation ; Rust remet en cause ce conflit. Grâce à l'équilibre entre ses puissantes capacités techniques et une bonne ergonomie de développement, Rust vous donne la possibilité de contrôler les détails de bas-niveau (comme l'utilisation de la mémoire) sans tous les soucis traditionnellement associés à ce genre de pratique.

À qui s'adresse Rust

Rust est idéal pour de nombreuses personnes pour diverses raisons. Analysons quelques-uns des groupes les plus importants.

Équipes de développeurs

Rust se révèle être un outil productif pour la collaboration entre de grandes équipes de développeurs ayant différents niveaux de connaissances en programmation système. Le code de bas-niveau est sujet à une multitude de bogues subtils, qui, dans la plupart des autres langages, ne peuvent être prévenus qu'au moyen de campagnes de test étendues et de minutieuses revues de code menées par des développeurs chevronnés. Avec Rust, le compilateur joue le rôle de gardien en refusant de compiler du code qui comprend ces bogues discrets et vicieux, y compris les bogues de concurrence. En travaillant avec le compilateur, l'équipe peut se concentrer sur la logique du programme plutôt que de traquer les bogues.

Rust offre aussi des outils de développement modernes au monde de la programmation système :

- Cargo, l'outil intégré de gestion de dépendances et de compilation, qui uniformise et facilite l'ajout, la compilation, et la gestion des dépendances dans l'écosystème Rust.

- Rustfmt, qui assure une cohérence de style de codage pour tous les développeurs.

- Le Rust Langage Server alimente les environnements de développement intégrés (IDE) pour la complétion du code et l'affichage direct des messages d'erreur.

En utilisant ces outils ainsi que d'autres dans l'écosystème Rust, les développeurs peuvent être plus productifs quand ils écrivent du code système.

Étudiants

Rust est conçu pour les étudiants et ceux qui s'intéressent à l'apprentissage des concepts système. En utilisant Rust, de nombreuses personnes ont appris des domaines comme le développement de systèmes d'exploitation. La communauté est très accueillante et répond volontiers aux questions des étudiants. Grâce à des initiatives comme ce livre, les équipes de Rust veulent rendre les notions système accessibles au plus grand nombre, particulièrement à ceux qui débutent dans la programmation.

Entreprises

Des centaines d'entreprises, petites et grosses, utilisent Rust en production pour différentes missions. Ils l'utilisent pour des outils en ligne de commande, des services web, des outils DevOps, des systèmes embarqués, de l'analyse et de la conversion audio et vidéo, des cryptomonnaies, de la bio-informatique, des moteurs de recherche, de l'internet des objets (IoT), de l'apprentissage automatique (marchine learning), et même des parties importantes du navigateur internet Firefox.

Développeurs de logiciel libre

Rust est ouvert aux personnes qui veulent développer le langage de programmation Rust, la communauté, les outils de développement et les bibliothèques. Nous serions ravis que vous contribuiez au langage Rust.

Les personnes qui recherchent la rapidité et la stabilité

Rust est une solution pour les personnes qui chérissent la rapidité et la stabilité dans un langage. Par rapidité, nous entendons la vitesse des programmes que vous pouvez créer avec Rust et la rapidité avec laquelle Rust vous permet de les écrire. Les vérifications du compilateur de Rust assurent la stabilité durant l'ajout de fonctionnalités ou le remaniement du code. Cela le démarque des langages qui ne font pas ces contrôles sur du code instable que le programme a hérité avec le temps, et que bien souvent les développeurs ont peur de modifier. En s'efforçant de mettre en place des abstractions sans coût, des fonctionnalités de haut-niveau qui compilent vers du code bas-niveau aussi rapide que s'il avait été écrit à la main, Rust fait en sorte que le code sûr soit aussi du code rapide.

Le langage Rust espère aider beaucoup d'autres utilisateurs ; ceux cités ici ne font partie que d'un univers bien plus grand. Globalement, la plus grande ambition de Rust est d'éradiquer les compromis auxquels les développeurs se soumettaient depuis des décennies en leur apportant sécurité et productivité, rapidité et ergonomie. Essayez Rust et vérifiez si ses décisions vous conviennent.

À qui est destiné ce livre

Ce livre suppose que vous avez écrit du code dans un autre langage de programmation mais ne suppose pas lequel. Nous avons essayé de rendre son contenu le plus accessible au plus grand nombre d'expériences de programmation possible. Nous ne nous évertuons pas à nous questionner sur ce qu'est la programmation ou comment l'envisager. Si vous êtes débutant en programmation, vous seriez mieux avisé en lisant un livre qui vous initie à la programmation.

Comment utiliser ce livre

Globalement, ce livre est prévu pour être lu dans l'ordre. Les chapitres suivants s'appuient sur les notions abordées dans les chapitres précédents, et lorsque les chapitres précédents ne peuvent pas approfondir un sujet, ce sera généralement fait dans un chapitre suivant.

Vous allez rencontrer deux différents types de chapitres dans ce livre : les chapitres théoriques et les chapitres de projet. Dans les chapitres théoriques, vous allez apprendre un sujet à propos de Rust. Dans un chapitre de projet, nous allons construire ensemble des petits programmes, pour appliquer ce que vous avez appris précédemment. Les chapitres 2, 12 et 20 sont des chapitres de projet ; les autres sont des chapitres théoriques.

Le chapitre 1 explique comment installer Rust, comment écrire un programme "Hello, world!" et comment utiliser Cargo, le gestionnaire de paquets et outil de compilation. Le chapitre 2 est une initiation pratique au langage Rust. Nous y aborderons des concepts de haut-niveau, et les chapitres suivants apporteront plus de détails. Si vous voulez vous salir les mains tout de suite, le chapitre 2 est l'endroit pour cela. Au début, vous pouvez même sauter le chapitre 3, qui aborde les fonctionnalités de Rust semblables aux autres langages de programmation, et passer directement au chapitre 4 pour en savoir plus sur le système de possession (ownership) de Rust. Toutefois, si vous êtes un apprenti particulièrement minutieux qui préfère apprendre chaque particularité avant de passer à la suivante, vous pouvez sauter le chapitre 2 et passer directement au chapitre 3, puis revenir au chapitre 2 lorsque vous souhaitez travailler sur un projet en appliquant les notions que vous avez apprises.

Le chapitre 5 traite des structures et des méthodes, et le chapitre 6 couvre les

énumérations, les expressions match, et la structure de contrôle if let.

Vous emploierez les structures et les énumérations pour créer des types

personnalisés avec Rust.

Au chapitre 7, vous apprendrez le système de modules de Rust et les règles de visibilité, afin d'organiser votre code et son interface de programmation applicative (API) publique. Le chapitre 8 traitera des structures de collections de données usuelles fournies par la bibliothèque standard, comme les vecteurs, les chaînes de caractères et les tables de hachage (hash maps). Le chapitre 9 explorera la philosophie et les techniques de gestion d'erreurs de Rust.

Le chapitre 10 nous plongera dans la généricité, les traits et

les durées de vie, qui vous donneront la capacité de créer du code qui s'adapte

à différents types. Le chapitre 11 traitera des techniques de test, qui restent

nécessaires malgré les garanties de sécurité de Rust, pour s'assurer que

la logique de votre programme est valide. Au chapitre 12, nous écrirons

notre propre implémentation d'un sous-ensemble des fonctionnalités du programme

en ligne de commande grep, qui recherche du texte dans des fichiers.

Pour ce faire, nous utiliserons de nombreuses notions abordées dans les

chapitres précédents.

Le chapitre 13 explorera les fermetures (closures) et itérateurs : ce sont les fonctionnalités de Rust inspirées des langages de programmation fonctionnels. Au chapitre 14, nous explorerons plus en profondeur Cargo et les bonnes pratiques pour partager vos propres bibliothèques avec les autres. Le chapitre 15 parlera de pointeurs intelligents qu'apporte la bibliothèque standard et des traits qui activent leurs fonctionnalités.

Au chapitre 16, nous passerons en revue les différents modes de programmation concurrente et comment Rust nous aide à développer dans des tâches parallèles sans crainte. Le chapitre 17 comparera les fonctionnalités de Rust aux principes de programmation orientée objet, que vous connaissez peut-être.

Le chapitre 18 est une référence sur les motifs et le filtrage de motif (pattern matching), qui sont des moyens puissants permettant de communiquer des idées dans les programmes Rust. Le chapitre 19 contient une foultitude de sujets avancés intéressants, comme le code Rust non sécurisé (unsafe), les macros et plus de détails sur les durées de vie, les traits, les types, les fonctions et les fermetures (closures).

Au chapitre 20, nous terminerons un projet dans lequel nous allons implémenter en bas-niveau un serveur web multitâches !

Et finalement, quelques annexes qui contiennent des informations utiles sur le langage sous forme de référentiels qui renvoient à d'autres documents. L'annexe A liste les mots-clés de Rust, l'annexe B couvre les opérateurs et symboles de Rust, l'annexe C parle des traits dérivables qu'apporte la bibliothèque standard, l'annexe D référence certains outils de développement utiles, et l'annexe E explique les différentes éditions de Rust.

Il n'y a pas de mauvaise manière de lire ce livre : si vous voulez sauter des étapes, allez-y ! Vous devrez alors peut-être revenir sur les chapitres précédents si vous éprouvez des difficultés. Mais faites comme bon vous semble.

Une composante importante du processus d'apprentissage de Rust est de comprendre comment lire les messages d'erreur qu'affiche le compilateur : ils vous guideront vers du code correct. Ainsi, nous citerons de nombreux exemples qui ne compilent pas, avec le message d'erreur que le compilateur devrait vous afficher dans chaque cas. C'est donc normal que dans certains cas, si vous copiez et exécutez un exemple au hasard, il ne compile pas ! Assurez-vous d'avoir lu le texte autour pour savoir si l'exemple que vous tentez de compiler doit échouer. Ferris va aussi vous aider à identifier du code qui ne devrait pas fonctionner :

| Ferris | Signification |

|---|---|

| Ce code ne compile pas ! | |

| Ce code panique ! | |

| Ce code ne se comporte pas comme voulu. |

Dans la plupart des cas, nous vous guiderons vers la version du code qui devrait fonctionner.

Code source

Les fichiers du code source qui a généré ce livre en anglais sont disponibles sur GitHub.

La version française est aussi disponible sur GitHub.

Traduction des termes

Voici les principaux termes techniques qui ont été traduits de l'anglais vers le français.

| Anglais | Français | Remarques |

|---|---|---|

| adaptor | adaptateur | - |

| ahead-of-time compilation | compilation anticipée | sigle : AOT |

| alias | alias | - |

| allocated | alloué | - |

| angle bracket | chevrons | - |

| annotate | indiquer | - |

| anti-pattern | anti-patron | - |

| Appendix | annexe | tout en minuscule (sauf en début de phrase) |

| append | ajouter | - |

| Application Programming Interface (API) | interface de programmation applicative (API) | - |

| assertion | vérification | - |

| assign | assigner | - |

| argument | argument / paramètre | - |

| arm | branche | dans une expression match |

| array | tableau | - |

| artifact | artéfact | - |

| associated function | fonction associée | - |

| attribute | attribut | - |

| backend | application dorsale | - |

| backtrace | retraçage | - |

| benchmark | benchmark | - |

| binary crate | crate binaire | s'utilise au féminin |

| buffer overread | lecture hors limites | - |

| n-bit number | nombre encodé sur n bits | - |

| blanket implementation | implémentation générale | - |

| blob | blob | - |

| boilerplate code | code standard | - |

| boolean | booléen | - |

| borrow | emprunt(er) | - |

| borrow checker | vérificateur d'emprunt | - |

| box | boite | - |

| buffer overread | sur-lecture de tampon | - |

| bug | bogue | - |

| build | compilation | - |

| build system | système de compilation | - |

| byte | octet | - |

| Cargo | Cargo | - |

| catchall value | valeur passe-partout | - |

| channel | canal | - |

| Chapter | chapitre | tout en minuscule (sauf en début de phrase) |

| CI system | système d'Intégration Continue | - |

| clause | clause | - |

| cleanup | nettoyage | - |

| closure | fermeture | - |

| code review | revue de code | - |

| coercion | extrapolation | - |

| collection | collection | - |

| command | commande | dans un terminal |

| commit | commit | - |

| compound | composé | - |

| concept chapter | chapitre théorique | - |

| concurrency | concurrence | - |

| concurrent | concurrent | - |

| concurrent programming | programmation concurrente | - |

| conditional | structure conditionnelle | - |

| cons list | liste de construction | - |

| constant | constant / constante | - |

| construct | instruction | - |

| constructor | constructeur | - |

| consuming adaptor | adaptateur de consommation | - |

| control flow construct | structure de contrôle | - |

| core of the error | message d'erreur | - |

| corruption | corruption / être corrompu | - |

| CPU | processeur | - |

| crash | plantage | - |

| crate | crate | nom féminin (une crate) |

| curly bracket | accolade | - |

| dangling | pendouillant | - |

| data race | accès concurrent | - |

| data representation | modèle de données | - |

| deadlock | interblocage | - |

| deallocate | désalloué | - |

| debug | déboguer | - |

| debugging | débogage | - |

| deep copy | copie en profondeur | - |

| dependency | dépendance | - |

| deref coercion | extrapolation de déréferencement | - |

| dereference operator | opérateur de déréférencement | - |

| dereferencing | déréférencement | - |

| design pattern | patron de conception | - |

| destructor | destructeur | - |

| destructure | déstructurer | - |

| DevOps | DevOps | - |

| directory | dossier | - |

| dot notation | la notation avec un point | - |

| double free | double libération | - |

| drop | libérér | - |

| elision | élision | - |

| enum | énumération | - |

| enumeration | énumération | - |

| enum’s variant | variante d'énumération | - |

| exploit | faille | - |

| expression | expression | - |

| field | champ | d'une structure |

| Figure | Illustration | - |

| flag | drapeau | pour les programmes en ligne de commande |

| float | nombre à virgule flottante | - |

| floating-point number | nombre à virgule flottante | - |

| framework | environnement de développement | - |

| frontend | interface frontale | - |

| fully qualified syntax | syntaxe totalement définie | - |

| function | fonction | - |

| functional programming | programmation fonctionnelle | - |

| garbage collector | ramasse-miettes | - |

| generics | génériques / généricité | - |

| generic type parameter | paramètre de type générique | - |

| getter | accesseur | - |

| glob | global | opérateur |

| global scope | portée globale | - |

| grapheme cluster | groupe de graphèmes | - |

| green thread | tâche virtuelle | - |

| guessing game | jeu de devinettes | - |

| handle | référence abstraite | - |

| hash | hash / relatif au hachage | - |

| hash map | table de hachage | - |

| heap | tas | - |

| Hello, world! | Hello, world! | - |

| high-level | haut niveau | - |

| identifier | identificateur | - |

| idiomatic | idéal | - |

| immutability | immuabilité | - |

| immutable | immuable | - |

| index | indice | - |

| indexing | indexation | - |

| input/output | entrée/sortie | sigle : IO |

| instance | instance | - |

| instantiate | instancier | créer une instance |

| integer literal | littéral d'entiers | - |

| integer overflow | dépassement d'entier | - |

| Integrated Development Environment (IDE) | environnement de développement intégré (IDE) | - |

| interior mutability | mutabilité interne | - |

| interrupt signal | signal d'arrêt | - |

| invalidate | neutraliser | - |

| IOT | internet des objets (IOT) | - |

| iterator | itérateur | - |

| iterator adaptor | adaptateur d'itération | - |

| job | mission | - |

| just-in-time compilation | compilation à la volée | sigle : JIT |

| keyword | mot-clé | - |

| lazy | évaluation paresseuse | comportement d'un itérateur |

| legacy code | code instable que le programme a hérité avec le temps | - |

| library | bibliothèque | - |

| library crate | crate de bibliothèque | s'utilise au féminin |

| lifetime | durée de vie | - |

| linker | linker | - |

| linter | analyse statique | - |

| literal value | valeur littérale | - |

| Listing | encart | tout en minuscule (sauf en début de phrase) |

| loop | boucle | - |

| low-level | bas niveau | - |

| machine learning | apprentissage automatique | - |

| macro | macro | - |

| main | main | - |

| map | tableau associatif | - |

| match guard | contrôle de correspondance | - |

| memory leak | fuite de mémoire | - |

| memory management | gestion de mémoire | - |

| message-passing | passage de messages | - |

| method | méthode | - |

| mock object | mock object | - |

| modern | récent | - |

| module | module | - |

| module system | système de modules | - |

| monomorphization | monomorphisation | - |

| move | déplacement | - |

| mutability | mutabilité | - |

| mutable | mutable | modifiable |

| mutate | muter | - |

| namespace | espace de nom | - |

| namespacing | l'espace de nom | - |

| nested (path) | (chemin) imbriqué | - |

| newtype pattern | motif newtype | - |

| nightly Rust | version expérimentale de Rust | - |

| Note | remarque | tout en minuscule (sauf en début de phrase) |

| numerical characters | chiffres | - |

| object-oriented language | langage orienté objet | - |

| operating system | système d'exploitation | - |

| output | sortie | - |

| overload | surcharge | - |

| owner | propriétaire | - |

| ownership | possession | - |

| package manager | système de gestion de paquets | - |

| panic | panique(r) | - |

| parallel programming | parallélisme | - |

| parallelism | parallélisme | - |

| parameter | paramètre | - |

| parse | interpréter | - |

| PATH | PATH | - |

| pattern | motif | - |

| pattern-matching | filtrage par motif | - |

| placeholder | espace réservé | {} pour fmt |

| pointer | pointeur | - |

| popping off the stack | dépiler | - |

| prelude | étape préliminaire | - |

| primitive obsession | obsession primitive | - |

| privacy | visibilité | en parlant des éléments d'un module |

| procedural macro | macro procédurale | - |

| process | processus | - |

| project chapter | chapitre de projet | - |

| propagate | propager | - |

| pushing onto the stack | empiler | - |

| race condition | situation de concurrence | - |

| raw identifier | identificateur brut | - |

| README | README | - |

| recursive type | type récursif | - |

| refactoring | remaniement | - |

| reference | référence | - |

| reference counting | compteur de références | - |

| reference cycle | boucle de références | - |

| release | publication | - |

| registry | registre | - |

| regression | régression | - |

| release | publication | - |

| remainder | modulo | opération % |

| reproducible build | compilation reproductible | - |

| Resource Acquisition Is Initialization (RAII) | l'acquisition d'une ressource est une initialisation (RAII) | - |

| return | retourner | - |

| run | exécuter | pour les programmes |

| Rustacean | Rustacé | - |

| section header | entête de section | - |

| semantic version | version sémantique | - |

| scalar | scalaire | - |

| scope | portée | - |

| script | script | - |

| secret | secret | - |

| section header | en-tête de section | - |

| semantic version | version sémantique | - |

| semantic versioning | versionnage sémantique | abréviation : SemVer |

| shadow | masquer | remplacer une variable par une autre de même nom |

| shadowing | masquage | - |

| shallow copy | copie superficielle | - |

| shell | terminal / invite de commande | - |

| shorthand | abréviation | - |

| sidebar | volet latéral | - |

| signature | signature | d'une fonction |

| signed | signé | - |

| slash | barre oblique | - |

| slice | slice | - |

| smart pointer | pointeur intelligent | - |

| snake case | snake case | - |

| snip | partie masquée ici | dans un encart |

| space | espace | ce mot est féminin quand on parle du caractère typographique |

| square brackets | crochets | - |

| stack | pile | - |

| stack overflow | débordement de pile | - |

| standard | standard (adj. inv.) / norme (n.f.) | - |

| standard error | erreur standard | - |

| standard input | entrée standard | - |

| standard library | bibliothèque standard | - |

| standard output | sortie standard | - |

| statement | instruction | - |

| statically typed | statiquement typé | - |

| string | chaîne de caractères | - |

| string literal | un littéral de chaîne de caractères | - |

String | String | nom féminin (une String) |

| struct | structure | - |

| submodule | sous-module | - |

| supertrait | supertrait | - |

| syntax sugar | sucre syntaxique | - |

| systems concept | notion système | - |

| systems-level | niveau système | - |

| systems-level code | code système | - |

| terminal | terminal | - |

| test double | double de test | - |

| thread | tâche | - |

| thread pool | groupe de tâches | - |

| token | jeton | - |

| trait | trait | - |

| trait bound | trait lié | - |

| trait object | objet trait | - |

| tree | arborescence | - |

| troubleshooting | dépannage | - |

| tuple | tuple | - |

| tuple struct | structure tuple | - |

| tuple enum | énumération tuple | - |

| type | type | - |

| type annotation | annotation de type | - |

| type inference | inférence de types | - |

| two’s complement | complément à deux | - |

| two’s complement wrapping | rebouclage du complément à deux | - |

| underlying operating system | système d'exploitation sous-jacent | - |

| underscore | tiret bas | le caractère _ |

| unit-like struct | structure unité | - |

| unit type | type unité | le () |

| unit value | valeur unité | - |

| unrolling | déroulage | pour une boucle à taille connue à la compilation |

| unsafe | non sécurisé | - |

| unsigned | sans signe (toujours positif) | - |

| unsigned | non signé | - |

| unwind | dérouler | (la pile) |

| user input | saisie utilisateur | - |

| variable | variable | - |

| variant | variante | d'une énumération |

| vector | vecteur | - |

| version control system (VCS) | système de gestion de versions (VCS) | - |

| vertical pipe | barre verticale | la barre ` |

| warning | avertissement | - |

| weak reference | référence faible | - |

| wildcard | joker | - |

| worker | opérateur | - |

| workspace | espace de travail | - |

| yank | déprécier | - |

| zero-cost abstraction | abstraction sans coût | - |

Prise en main

Démarrons notre périple avec Rust ! Il y a beaucoup à apprendre, mais chaque aventure doit commencer quelque part. Dans ce chapitre, nous allons aborder :

- L'installation de Rust sur Linux, macOS et Windows

- L'écriture d'un programme qui affiche

Hello, world! - L'utilisation de

cargo, le gestionnaire de paquets et système de compilation de Rust

Installation

La première étape consiste à installer Rust. Nous allons télécharger Rust via

rustup, un outil en ligne de commande conçu pour gérer les versions de Rust et

les outils qui leur sont associés. Vous allez avoir besoin d'une connexion

Internet pour le téléchargement.

Note : si vous préférez ne pas utiliser

rustuppour une raison ou une autre, vous pouvez vous référer à la page des autres moyens d'installation de Rust pour d'autres méthodes d'installation.

L'étape suivante est d'installer la dernière version stable du compilateur Rust. La garantie de stabilité de Rust assurera que tous les exemples dans le livre qui se compilent bien vont continuer à se compiler avec les nouvelles versions de Rust. La sortie peut varier légèrement d'une version à une autre, car Rust améliore souvent les messages d'erreur et les avertissements. En résumé, toute nouvelle version stable de Rust que vous installez de cette manière devrait fonctionner en cohérence avec le contenu de ce livre.

La notation en ligne de commande

Dans ce chapitre et les suivants dans le livre, nous allons montrer quelques commandes tapées dans le terminal. Les lignes que vous devrez écrire dans le terminal commencent toutes par

$. Vous n'avez pas besoin d'écrire le caractère$; il marque le début de chaque commande. Les lignes qui ne commencent pas par$montrent généralement le résultat de la commande précédente. De plus, les exemples propres à PowerShell utiliseront>plutôt que$.

Installer rustup sur Linux ou macOS

Si vous utilisez Linux ou macOS, ouvrez un terminal et écrivez la commande suivante :

$ curl --proto '=https' --tlsv1.2 https://sh.rustup.rs -sSf | sh

Cette commande télécharge un script et lance l'installation de l'outil rustup,

qui va installer la dernière version stable de Rust. Il est possible que l'on

vous demande votre mot de passe. Si l'installation se déroule bien, vous

devriez voir la ligne suivante s'afficher :

Rust is installed now. Great!

Vous aurez aussi besoin d'un linker, qui est un programme que Rust utilise pour regrouper ses multiples résultats de compilation dans un unique fichier. Il est probable que vous en ayez déjà un d'installé, mais si vous avez des erreurs à propos du linker, cela veut dire vous devrez installer un compilateur de langage C, qui inclura généralement un linker. Un compilateur est parfois utile car certains paquets Rust communs nécessitent du code C et auront besoin d'un compilateur C.

Sur macOS, vous pouvez obtenir un compilateur C en lançant la commande :

$ xcode-select --install

Les utilisateurs de Linux doivent généralement installer GCC ou Clang, en fonction

de la documentation de leur distribution. Par exemple, si vous utilisez Ubuntu,

vous pouvez installer le paquet build-essential.

Installer rustup sous Windows

Sous Windows, il faut aller sur https://www.rust-lang.org/tools/install et suivre les instructions pour installer Rust. À un moment donné durant l'installation, vous aurez un message vous expliquant qu'il va vous falloir l'outil de compilation C++ pour Visual Studio 2013 ou plus récent. La méthode la plus facile pour obtenir les outils de compilation est d'installer Build Tools pour Visual Studio 2019. Lorsque vous aurez à sélectionner les composants à installer, assurez-vous que les “Outils de compilation C++” sont bien sélectionnés, et que le SDK Windows 10 et les paquets de langage Anglais sont bien inclus.

La suite de ce livre utilisera des commandes qui fonctionnent à la fois dans cmd.exe et PowerShell. S'il y a des différences particulières, nous vous expliquerons lesquelles utiliser.

Mettre à jour et désinstaller

Après avoir installé Rust avec rustup, la mise à jour vers la dernière version

est facile. Dans votre terminal, lancez le script de mise à jour suivant :

$ rustup update

Pour désinstaller Rust et rustup, exécutez le script de désinstallation

suivant dans votre terminal :

$ rustup self uninstall

Dépannage

Pour vérifier si Rust est correctement installé, ouvrez un terminal et entrez cette ligne :

$ rustc --version

Vous devriez voir le numéro de version, le hash de commit, et la date de commit de la dernière version stable qui a été publiée, au format suivant :

rustc x.y.z (abcabcabc yyyy-mm-dd)

Si vous voyez cette information, c'est que vous avez installé Rust avec succès !

Si vous ne voyez pas cette information et que vous êtes sous Windows, vérifiez

que Rust est présent dans votre variable d'environnement système %PATH%. Si

tout est correct et que Rust ne fonctionne toujours pas, il y a quelques

endroits où vous pourrez trouver de l'aide. Le plus accessible est le

canal #beginners sur le Discord officiel de Rust. Là-bas, vous pouvez

dialoguer en ligne avec d'autres Rustacés (un surnom ridicule que nous nous

donnons entre nous) qui pourront vous aider. D'autres bonnes sources de données

sont le forum d'utilisateurs et Stack Overflow.

Documentation en local

L'installation de Rust embarque aussi une copie de la documentation en local

pour que vous puissiez la lire hors ligne. Lancez rustup doc afin d'ouvrir la

documentation locale dans votre navigateur.

À chaque fois que vous n'êtes pas sûr de ce que fait un type ou une fonction fournie par la bibliothèque standard ou que vous ne savez pas comment l'utiliser, utilisez cette documentation de l'interface de programmation applicative (API) pour le savoir !

Hello, World!

Maintenant que vous avez installé Rust, écrivons notre premier programme Rust. Lorsqu'on apprend un nouveau langage, il est de tradition d'écrire un petit programme qui écrit le texte "Hello, world!" à l'écran, donc c'est ce que nous allons faire !

Note : ce livre part du principe que vous êtes familier avec la ligne de commande. Rust n'impose pas d'exigences sur votre éditeur, vos outils ou l'endroit où vous mettez votre code, donc si vous préférez utiliser un environnement de développement intégré (IDE) au lieu de la ligne de commande, vous êtes libre d'utiliser votre IDE favori. De nombreux IDE prennent en charge Rust à des degrés divers ; consultez la documentation de l'IDE pour plus d'informations. Récemment, l'équipe Rust s'est attelée à améliorer l'intégration dans les IDE et des progrès ont rapidement été faits dans ce domaine !

Créer un dossier projet

Nous allons commencer par créer un dossier pour y ranger le code Rust. Là où vous mettez votre code n'est pas important pour Rust, mais pour les exercices et projets de ce livre, nous vous suggérons de créer un dossier projects dans votre dossier utilisateur et de ranger tous vos projets là-dedans.

Ouvrez un terminal et écrivez les commandes suivantes pour créer un dossier projects et un dossier pour le projet “Hello, world!” à l'intérieur de ce dossier projects.

Sous Linux, macOS et PowerShell sous Windows, écrivez ceci :

$ mkdir ~/projects

$ cd ~/projects

$ mkdir hello_world

$ cd hello_world

Avec CMD sous Windows, écrivez ceci :

> mkdir "%USERPROFILE%\projects"

> cd /d "%USERPROFILE%\projects"

> mkdir hello_world

> cd hello_world

Écrire et exécuter un programme Rust

Ensuite, créez un nouveau fichier source et appelez-le main.rs. Les fichiers

Rust se terminent toujours par l'extension .rs. Si vous utilisez plusieurs

mots dans votre nom de fichier, utilisez un tiret bas (_) pour

les séparer. Par exemple, vous devriez utiliser hello_world.rs au lieu de

helloworld.rs.

Maintenant, ouvrez le fichier main.rs que vous venez de créer et entrez le code de l'encart 1-1.

Fichier : main.rs

fn main() { println!("Hello, world!"); }

Encart 1-1 : Un programme qui affiche Hello, world!

Enregistrez le fichier et retournez dans votre terminal. Sur Linux ou macOS, écrivez les commandes suivantes pour compiler et exécuter le fichier :

$ rustc main.rs

$ ./main

Hello, world!

Sur Windows, écrivez la commande .\main.exe à la place de .\main :

> rustc main.rs

> .\main.exe

Hello, world!

Peu importe votre système d'exploitation, la chaîne de caractères

Hello, world! devrait s'écrire dans votre terminal. Si cela ne s'affiche pas,

référez-vous à la partie "Dépannage" du

chapitre d'installation pour vous aider.

Si Hello, world! s'affiche, félicitations ! Vous avez officiellement écrit un

programme Rust. Cela fait de vous un développeur Rust — bienvenue !

Structure d'un programme Rust

Regardons en détail ce qui s'est passé dans votre programme “Hello, world!”. Voici le premier morceau du puzzle :

fn main() { }

Ces lignes définissent une fonction dans Rust. La fonction main est spéciale :

c'est toujours le premier code qui est exécuté dans tous les programmes

en Rust. La première ligne déclare une fonction qui s'appelle main, qui n'a

pas de paramètre et qui ne retourne aucune valeur. S'il y avait des paramètres,

ils seraient placés entre les parenthèses ().

À noter en outre que le corps de la fonction est placé entre des accolades

{}. Rust en a besoin autour du corps de chaque fonction. C'est une

bonne pratique d'insérer l'accolade ouvrante sur la même ligne que la

déclaration de la fonction, en ajoutant une espace entre les deux.

Si vous souhaitez formater le code de vos projets Rust de manière standardisé,

vous pouvez utiliser un outil de formatage automatique tel que rustfmt.

L'équipe de Rust a intégré cet outil dans la distribution standard de Rust,

comme pour rustc par exemple, donc il est probablement déjà installé sur votre

ordinateur ! Consultez la documentation en ligne pour en savoir plus.

À l'intérieur de la fonction main, nous avons le code suivant :

#![allow(unused)] fn main() { println!("Hello, world!"); }

Cette ligne fait tout le travail dans ce petit programme : il écrit le texte à l'écran. Il y a quatre détails importants à noter ici.

Premièrement, le style de Rust est d'indenter avec quatre espaces, et non pas avec une tabulation.

Deuxièmement, println! fait appel à une macro Rust. S'il appelait une

fonction à la place, cela serait écrit println (sans le !). Nous aborderons

les macros Rust plus en détail dans le chapitre 19. Pour l'instant, vous avez

juste à savoir qu'utiliser un ! signifie que vous utilisez une macro plutôt

qu'une fonction classique. Les macros ne suivent pas toujours les mêmes règles

que les fonctions.

Troisièmement, vous voyez la chaîne de caractères "Hello, world!". Nous

envoyons cette chaîne en argument à println! et cette chaîne est affichée

à l'écran.

Quatrièmement, nous terminons la ligne avec un point-virgule (;), qui indique

que cette expression est terminée et que la suivante est prête à commencer. La

plupart des lignes de Rust se terminent avec un point-virgule.

La compilation et l'exécution sont des étapes séparées

Vous venez de lancer un nouveau programme fraîchement créé, donc penchons-nous sur chaque étape du processus.

Avant de lancer un programme Rust, vous devez le compiler en utilisant le

compilateur Rust en entrant la commande rustc et en lui passant le nom de

votre fichier source, comme ceci :

$ rustc main.rs

Si vous avez de l'expérience en C ou en C++, vous observerez des similarités

avec gcc ou clang.

Après avoir compilé avec succès, Rust produit un binaire exécutable.

Avec Linux, macOS et PowerShell sous Windows, vous pouvez voir l'exécutable en

utilisant la commande ls dans votre terminal. Avec Linux et macOS,

vous devriez voir deux fichiers. Avec PowerShell sous Windows, vous devriez voir

les trois mêmes fichiers que vous verriez en utilisant CMD.

$ ls

main main.rs

Avec CMD sous Windows, vous devez saisir la commande suivante :

> dir /B %= l'option /B demande à n'afficher que les noms de fichiers =%

main.exe

main.pdb

main.rs

Ceci affiche le fichier de code source avec l'extension .rs, le fichier exécutable (main.exe sous Windows, mais main sur toutes les autres plateformes) et, quand on utilise Windows, un fichier qui contient des informations de débogage avec l'extension .pdb. Dans ce dossier, vous pouvez exécuter le fichier main ou main.exe comme ceci :

$ ./main # ou .\main.exe sous Windows

Si main.rs était votre programme “Hello, world!”, cette ligne devrait afficher

Hello, world! dans votre terminal.

Si vous connaissez un langage dynamique, comme Ruby, Python, ou JavaScript, vous n'avez peut-être pas l'habitude de compiler puis lancer votre programme dans des étapes séparées. Rust est un langage à compilation anticipée, ce qui veut dire que vous pouvez compiler le programme et le donner à quelqu'un d'autre, et il peut l'exécuter sans avoir Rust d'installé. Si vous donnez à quelqu'un un fichier .rb, .py ou .js, il a besoin d'avoir respectivement un interpréteur Ruby, Python, ou Javascript d'installé. Cependant, avec ces langages, vous n'avez besoin que d'une seule commande pour compiler et exécuter votre programme. Dans la conception d'un langage, tout est une question de compromis.

Compiler avec rustc peut suffire pour de petits programmes, mais au fur et à

mesure que votre programme grandit, vous allez avoir besoin de régler plus

d'options et faciliter le partage de votre code. À la page suivante, nous allons

découvrir l'outil Cargo, qui va vous aider à écrire des programmes Rust à

l'épreuve de la réalité.

Hello, Cargo!

Cargo est le système de compilation et de gestion de paquets de Rust. La plupart des Rustacés utilisent cet outil pour gérer les projets Rust, car Cargo s'occupe de nombreuses tâches pour vous, comme compiler votre code, télécharger les bibliothèques dont votre code dépend, et compiler ces bibliothèques. (On appelle dépendance une bibliothèque nécessaire pour votre code.)

Des programmes Rust très simples, comme le petit que nous avons écrit précédemment, n'ont pas de dépendance. Donc si nous avions compilé le projet “Hello, world!” avec Cargo, cela n'aurait fait appel qu'à la fonctionnalité de Cargo qui s'occupe de la compilation de votre code. Quand vous écrirez des programmes Rust plus complexes, vous ajouterez des dépendances, et si vous créez un projet en utilisant Cargo, l'ajout des dépendances sera plus facile à faire.

Comme la large majorité des projets Rust utilisent Cargo, la suite de ce livre va supposer que vous utilisez aussi Cargo. Cargo s'installe avec Rust si vous avez utilisé l'installateur officiel présenté dans la section “Installation”. Si vous avez installé Rust autrement, vérifiez que Cargo est installé en utilisant la commande suivante dans votre terminal :

$ cargo --version

Si vous voyez un numéro de version, c'est qu'il est installé ! Si vous voyez une

erreur comme Commande non trouvée (ou command not found), alors consultez la

documentation de votre méthode d'installation pour savoir comment installer

séparément Cargo.

Créer un projet avec Cargo

Créons un nouveau projet en utilisant Cargo et analysons les différences avec notre projet initial “Hello, world!”. Retournez dans votre dossier projects (ou là où vous avez décidé d'enregistrer votre code). Ensuite, sur n'importe quel système d'exploitation, lancez les commandes suivantes :

$ cargo new hello_cargo

$ cd hello_cargo

La première commande a crée un nouveau dossier appelé hello_cargo. Nous avons appelé notre projet hello_cargo, et Cargo crée ses fichiers dans un dossier avec le même nom.

Rendez-vous dans le dossier hello_cargo et afficher la liste des fichiers. Vous constaterez que Cargo a généré deux fichiers et un dossier pour nous : un fichier Cargo.toml et un dossier src avec un fichier main.rs à l'intérieur.

Il a aussi créé un nouveau dépôt Git ainsi qu'un fichier .gitignore. Les

fichiers de Git ne seront pas générés si vous lancez cargo new au sein d'un

dépôt Git ; vous pouvez désactiver ce comportement temporairement en utilisant

cargo new --vcs=git.

Note : Git est un système de gestion de versions très répandu. Vous pouvez changer

cargo newpour utiliser un autre système de gestion de versions ou ne pas en utiliser du tout en écrivant le drapeau--vcs. Lancezcargo new --helppour en savoir plus sur les options disponibles.

Ouvrez Cargo.toml dans votre éditeur de texte favori. Son contenu devrait être similaire au code dans l'encart 1-2.

Fichier : Cargo.toml

[package]

name = "hello_cargo"

version = "0.1.0"

edition = "2021"

[dependencies]

Encart 1-2 : Contenu de Cargo.toml généré par cargo new

Ce fichier est au format TOML (Tom’s Obvious, Minimal Language), qui est le format de configuration de Cargo.

La première ligne, [package], est un en-tête de section qui indique que les

instructions suivantes configurent un paquet. Au fur et à mesure que nous

ajouterons plus de détails à ce fichier, nous ajouterons des sections

supplémentaires.

Les trois lignes suivantes définissent les informations de configuration dont

Cargo a besoin pour compiler votre programme : le nom, la version, et l'édition

de Rust à utiliser. Nous aborderons la clé edition dans

l'Annexe E.

La dernière ligne, [dependencies], est le début d'une section qui vous permet

de lister les dépendances de votre projet. Dans Rust, les paquets de code sont

désignés sous le nom de crates. Nous n'allons pas utiliser de crate pour ce

projet, mais nous le ferons pour le premier projet au chapitre 2 ; nous

utiliserons alors cette section à ce moment-là.

Maintenant, ouvrez src/main.rs et jetez-y un coup d'œil :

Fichier : src/main.rs

fn main() { println!("Hello, world!"); }

Cargo a généré un programme “Hello, world!” pour vous, exactement comme celui que nous avons écrit dans l'encart 1-1 ! Pour le moment, les seules différences entre notre projet précédent et le projet que Cargo a généré sont que Cargo a placé le code dans le dossier src, et que nous avons un fichier de configuration Cargo.toml à la racine du dossier projet.

Cargo prévoit de stocker vos fichiers sources dans le dossier src. Le dossier parent est là uniquement pour les fichiers README, pour les informations à propos de la licence, pour les fichiers de configuration et tout ce qui n'est pas directement relié à votre code. Utiliser Cargo vous aide à structurer vos projets. Il y a un endroit pour tout, et tout est à sa place.

Si vous commencez un projet sans utiliser Cargo, comme nous l'avons fait avec le projet “Hello, world!”, vous pouvez le transformer en projet qui utilise Cargo. Déplacez le code de votre projet dans un dossier src et créez un fichier Cargo.toml adéquat.

Compiler et exécuter un projet Cargo

Maintenant, regardons ce qu'il y a de différent quand nous compilons et exécutons le programme “Hello, world!” avec Cargo ! À l'intérieur de votre dossier hello_cargo, compilez votre projet en utilisant la commande suivante :

$ cargo build

Compiling hello_cargo v0.1.0 (file:///projects/hello_cargo)

Finished dev [unoptimized + debuginfo] target(s) in 2.85 secs

Cette commande crée un fichier exécutable dans target/debug/hello_cargo (ou target\debug\hello_cargo.exe sous Windows) plutôt que de le déposer dans votre dossier courant. Vous pouvez lancer l'exécutable avec cette commande :

$ ./target/debug/hello_cargo # ou .\target\debug\hello_cargo.exe sous Windows

Hello, world!

Si tout s'est bien passé, Hello, world! devrait s'afficher dans le terminal.

Lancer cargo build pour la première fois devrait aussi mener Cargo à créer

un nouveau fichier à la racine du dossier projet : Cargo.lock. Ce fichier

garde une trace des versions exactes des dépendances de votre

projet. Ce projet n'a pas de dépendance, donc le fichier est un peu vide. Vous

n'aurez jamais besoin de changer ce fichier manuellement ; Cargo va gérer son

contenu pour vous.

Nous venons de compiler un projet avec cargo build avant de l'exécuter avec

./target/debug/hello_cargo, mais nous pouvons aussi utiliser cargo run pour

compiler le code et ensuite lancer l'exécutable dans une seule et même

commande :

$ cargo run

Finished dev [unoptimized + debuginfo] target(s) in 0.0 secs

Running `target/debug/hello_cargo`

Hello, world!

Notez que cette fois-ci, nous ne voyons pas de messages indiquant que Cargo a

compilé hello_cargo. Cargo a détecté que les fichiers n'avaient pas changé,

donc il a juste exécuté le binaire. Si vous aviez modifié votre code source,

Cargo aurait recompilé le projet avant de le lancer, et vous auriez eu les

messages suivants :

$ cargo run

Compiling hello_cargo v0.1.0 (file:///projects/hello_cargo)

Finished dev [unoptimized + debuginfo] target(s) in 0.33 secs

Running `target/debug/hello_cargo`

Hello, world!

Cargo fournit aussi une commande appelée cargo check. Elle vérifie rapidement

votre code pour s'assurer qu'il est compilable, mais ne produit pas

d'exécutable :

$ cargo check

Checking hello_cargo v0.1.0 (file:///projects/hello_cargo)

Finished dev [unoptimized + debuginfo] target(s) in 0.32 secs

Dans quel cas n'aurions-nous pas besoin d'un exécutable ? Parfois, cargo check

est bien plus rapide que cargo build, car il saute l'étape de création de

l'exécutable. Si vous vérifiez votre travail continuellement pendant que vous

écrivez votre code, utiliser cargo check accélèrera le processus ! C'est

pourquoi de nombreux Rustacés utilisent périodiquement cargo check quand ils

écrivent leur programme afin de s'assurer qu'il compile. Ensuite, ils lancent

cargo build quand ils sont prêts à utiliser l'exécutable.

Récapitulons ce que nous avons appris sur Cargo :

- Nous pouvons créer un projet en utilisant

cargo new. - Nous pouvons compiler un projet en utilisant

cargo build. - Nous pouvons compiler puis exécuter un projet en une seule fois en utilisant

cargo run. - Nous pouvons compiler un projet sans produire de binaire afin de vérifier

l'existance d'erreurs en utilisant

cargo check. - Au lieu d'enregistrer le résultat de la compilation dans le même dossier que votre code, Cargo l'enregistre dans le dossier target/debug.

Un autre avantage d'utiliser Cargo est que les commandes sont les mêmes peu importe le système d'exploitation que vous utilisez. Donc à partir de maintenant, nous n'allons plus faire d'opérations spécifiques à Linux et macOS par rapport à Windows.

Compiler pour diffuser

Quand votre projet est finalement prêt à être diffusé, vous pouvez utiliser

cargo build --release pour le compiler en l'optimisant. Cette commande va

créer un exécutable dans target/release au lieu de target/debug. Ces

optimisations rendent votre code Rust plus rapide à exécuter, mais l'utiliser

rallonge le temps de compilation de votre programme. C'est pourquoi il y a deux

différents profils : un pour le développement, quand vous voulez recompiler

rapidement et souvent, et un autre pour compiler le programme final qui sera

livré à un utilisateur, qui n'aura pas besoin d'être recompilé à plusieurs

reprises et qui s'exécutera aussi vite que possible. Si vous évaluez le temps

d'exécution de votre code, assurez-vous de lancer cargo build --release et

d'utiliser l'exécutable dans target/release pour vos bancs de test.

Cargo comme convention

Pour des projets simples, Cargo n'apporte pas grand-chose par rapport à rustc,

mais il vous montrera son intérêt au fur et à mesure

que vos programmes deviendront plus complexes. Avec des projets complexes

composés de plusieurs crates, il est plus facile de laisser Cargo prendre en

charge la coordination de la compilation.

Même si le projet hello_cargo est simple, il utilise maintenant une grande

partie de l'outillage que vous rencontrerez dans votre carrière avec Rust. En

effet, pour travailler sur n'importe quel projet Rust existant, vous n'avez

qu'à saisir les commandes suivantes pour télécharger le code avec Git, vous

déplacer dans le dossier projet et compiler :

$ git clone example.org/projet_quelconque

$ cd projet_quelconque

$ cargo build

Pour plus d'informations à propos de Cargo, vous pouvez consulter sa documentation.

Résumé

Vous êtes déjà bien lancé dans votre périple avec Rust ! Dans ce chapitre, vous avez appris comment :

- Installer la dernière version stable de Rust en utilisant

rustup - Mettre à jour Rust vers une nouvelle version

- Ouvrir la documentation installée en local

- Écrire et exécuter un programme “Hello, world!” en utilisant directement

rustc - Créer et exécuter un nouveau projet en utilisant les conventions de Cargo

C'est le moment idéal pour construire un programme plus ambitieux pour s'habituer à lire et écrire du code Rust. Donc, au chapitre 2, nous allons écrire un programme de jeu de devinettes. Si vous préférez commencer par apprendre comment les principes de programmation de base fonctionnent avec Rust, rendez-vous au chapitre 3, puis revenez au chapitre 2.

Programmer le jeu du plus ou du moins

Entrons dans le vif du sujet en travaillant ensemble sur un projet concret !

Ce chapitre présente quelques concepts couramment utilisés en Rust en vous

montrant comment les utiliser dans un véritable programme. Nous aborderons

notamment les instructions let et match, les méthodes et fonctions

associées, l'utilisation des crates, et bien plus encore ! Dans les chapitres

suivants, nous approfondirons ces notions. Dans ce chapitre, vous n'allez

exercer que les principes de base.

Nous allons coder un programme fréquemment réalisé par les débutants en programmation : le jeu du plus ou du moins. Le principe de ce jeu est le suivant : le programme va tirer au sort un nombre entre 1 et 100. Il invitera ensuite le joueur à saisir un nombre qu'il pense deviner. Après la saisie, le programme indiquera si le nombre saisi par le joueur est trop grand ou trop petit. Si le nombre saisi est le bon, le jeu affichera un message de félicitations et se fermera.

Mise en place d'un nouveau projet

Pour créer un nouveau projet, rendez-vous dans le dossier projects que vous avez créé au chapitre 1 et utilisez Cargo pour créer votre projet, comme ceci :

$ cargo new jeu_du_plus_ou_du_moins

$ cd jeu_du_plus_ou_du_moins

La première commande, cargo new, prend comme premier argument le nom de notre

projet (jeu_du_plus_ou_du_moins). La seconde commande nous déplace dans le

dossier de notre nouveau projet créé par Cargo.

Regardons le fichier Cargo.toml qui a été généré :

Fichier : Cargo.toml

[package]

name = "jeu_du_plus_ou_du_moins"

version = "0.1.0"

edition = "2021"

# See more keys and their definitions at https://doc.rust-lang.org/cargo/reference/manifest.html

[dependencies]

Comme vous l'avez expérimenté dans le chapitre 1, cargo new génère un

programme “Hello, world!” pour vous. Ouvrez le fichier src/main.rs :

Fichier : src/main.rs

fn main() { println!("Hello, world!"); }

Maintenant, lançons la compilation de ce programme “Hello, world!” et

son exécution en une seule commande avec cargo run :

$ cargo run

Compiling jeu_du_plus_ou_du_moins v0.1.0 (file:///projects/jeu_du_plus_ou_du_moins)

Finished dev [unoptimized + debuginfo] target(s) in 1.50s

Running `target/debug/jeu_du_plus_ou_du_moins`

Hello, world!

Cette commande run est très pratique lorsqu'on souhaite itérer rapidement

sur un projet, comme c'est le cas ici, pour tester rapidement chaque

modification avant de passer à la suivante.

Ouvrez à nouveau le fichier src/main.rs. C'est dans ce fichier que nous écrirons la totalité de notre code.

Traitement d'un nombre saisi

La première partie du programme consiste à demander au joueur de saisir du texte, à traiter cette saisie, et à vérifier que la saisie correspond au format attendu. Commençons par permettre au joueur de saisir son nombre. Entrez le code de l'encart 2-1 dans le fichier src/main.rs.

Fichier : src/main.rs

use std::io;

fn main() {

println!("Devinez le nombre !");

println!("Veuillez entrer un nombre.");

let mut supposition = String::new();

io::stdin()

.read_line(&mut supposition)

.expect("Échec de la lecture de l'entrée utilisateur");

println!("Votre nombre : {}", supposition);

}

Encart 2-1 : Code permettant de récupérer une saisie utilisateur et de l'afficher

Ce code contient beaucoup d'informations, nous allons donc l'analyser petit

à petit. Pour obtenir la saisie utilisateur et ensuite l'afficher, nous avons

besoin d'importer la bibliothèque d'entrée/sortie io (initiales

de input/output) afin de pouvoir l'utiliser. La bibliothèque io provient de

la bibliothèque standard, connue sous le nom de std :

use std::io;

fn main() {

println!("Devinez le nombre !");

println!("Veuillez entrer un nombre.");

let mut supposition = String::new();

io::stdin()

.read_line(&mut supposition)

.expect("Échec de la lecture de l'entrée utilisateur");

println!("Votre nombre : {}", supposition);

}

Par défaut, Rust importe dans la portée de tous les programmes quelques fonctionnalités définies dans la bibliothèque standard. Cela s'appelle l'étape préliminaire (the prelude), et vous pouvez en savoir plus dans sa documentation de la bibliothèque standard.

Si vous

voulez utiliser un type qui ne s'y trouve pas, vous devrez l'importer

explicitement avec l'instruction use. L'utilisation de la bibliothèque

std::io vous apporte de nombreuses fonctionnalités utiles, comme ici la

possibilité de récupérer une saisie utilisateur.

Comme vous l'avez vu au chapitre 1, la fonction main est le point d'entrée

du programme :

use std::io;

fn main() {

println!("Devinez le nombre !");

println!("Veuillez entrer un nombre.");

let mut supposition = String::new();

io::stdin()

.read_line(&mut supposition)

.expect("Échec de la lecture de l'entrée utilisateur");

println!("Votre nombre : {}", supposition);

}

Le mot clé fn déclare une nouvelle fonction, les parenthèses () indiquent

que cette fonction n'accepte aucun paramètre, et l'accolade ouvrante { marque

le début du corps de la fonction.

Comme vous l'avez également appris au chapitre 1, println! est une macro qui

affiche une chaîne de caractères à l'écran :

use std::io;

fn main() {

println!("Devinez le nombre !");

println!("Veuillez entrer un nombre.");

let mut supposition = String::new();

io::stdin()

.read_line(&mut supposition)

.expect("Échec de la lecture de l'entrée utilisateur");

println!("Votre nombre : {}", supposition);

}

Ce code affiche du texte qui indique le titre de notre jeu, et un autre qui demande au joueur d'entrer un nombre.

Enregistrer des données dans des variables

Ensuite, on crée une variable pour stocker la saisie de l'utilisateur, comme ceci :

use std::io;

fn main() {

println!("Devinez le nombre !");

println!("Veuillez entrer un nombre.");

let mut supposition = String::new();

io::stdin()

.read_line(&mut supposition)

.expect("Échec de la lecture de l'entrée utilisateur");

println!("Votre nombre : {}", supposition);

}

Le programme commence à devenir intéressant ! Il se passe beaucoup de choses

dans cette petite ligne. Nous utilisons l'instruction let pour créer la

variable. Voici un autre exemple :

let pommes = 5;

Cette ligne permet de créer une nouvelle variable nommée pommmes et à lui

assigner la valeur 5. Par défaut en Rust, les variables sont immuables.

Nous aborderons plus en détail cette notion dans la section “Variables et

Mutabilité” au chapitre 3. Pour

rendre une variable mutable (c'est-à-dire modifiable), nous ajoutons mut

devant le nom de la variable :

#![allow(unused)] fn main() { let pommes = 5; // immuable let mut bananes = 5; // mutable, modifiable }

Remarque : La syntaxe

//permet de commencer un commentaire qui s'étend jusqu'à la fin de la ligne. Rust ignore tout ce qu'il y a dans un commentaire. Nous verrons plus en détail les commentaires dans le chapitre 3.

Lorsque vous revenez sur le jeu du plus ou du moins, vous comprenez donc

maintenant que la ligne let mut supposition permet de créer une variable

mutable nommée supposition. Le signe égal (=) indique à Rust que nous

voulons désormais lier quelquechose à la variable. A la droite du signe égal,

nous avons la valeur liée à supposition, qui est ici le résultat de

l'utilisation de String::new, qui est une fonction qui retourne une nouvelle

instance de String.

String est un type de chaîne de caractères fourni

par la bibliothèque standard, qui est une portion de texte encodée en UTF-8 et

dont la longueur peut augmenter.

La syntaxe :: dans String::new() indique que new est une fonction

associée au type String. Une fonction associée est une fonction qui est

implémentée sur un type, ici String. Cette fonction new crée une nouvelle

chaîne de caractères vide, une nouvelle String. Vous trouverez fréquemment

une fonction new sur d'autres types, car c'est un nom souvent donné à une

fonction qui crée une nouvelle valeur ou instance d'un type.

En définitif, la ligne let mut supposition = String::new(); crée une nouvelle

variable mutable qui contient une nouvelle chaîne de caractères vide, une

instance de String. Ouf !

Recueillir la saisie utilisateur

Rappelez-vous que nous avons importé les fonctionnalités d'entrée/sortie de la

bibliothèque standard avec use std::io; à la première ligne de notre

programme. Nous allons maintenant appeler la fonction stdin du module io,

qui va nous permettre de traiter la saisie utilisateur :

use std::io;

fn main() {

println!("Devinez le nombre !");

println!("Veuillez entrer un nombre.");

let mut supposition = String::new();

io::stdin()

.read_line(&mut supposition)

.expect("Échec de la lecture de l'entrée utilisateur");

println!("Votre nombre : {}", supposition);

}

Si nous n'avions pas importé la bibliothèque io avec use std::io au début

du programme, on aurait toujours pu utiliser la fonction en écrivant l'appel à

la fonction de cette manière : std::io::stdin. La fonction stdin retourne

une instance de std::io::Stdin, qui est un type qui

représente une référence abstraite (handle) vers l'entrée standard du

terminal dans lequel vous avez lancé le programme.

Ensuite, la ligne .read_line(&mut supposition) appelle la méthode

read_line sur l'entrée standard afin d'obtenir

la saisie utilisateur.

Nous passons aussi &mut supposition en argument de read_line pour lui

indiquer dans quelle chaîne de caractère il faut stocker la saisie utilisateur.

Le but final de read_line est de récupérer tout ce que l'utilisateur écrit

dans l'entrée standard et de l'ajouter à la fin d'une chaîne de caractères

(sans écraser son contenu) ; c'est pourquoi nous passons cette chaîne de

caractères en argument. Cet argument doit être mutable pour que read_line

puisse en modifier le contenu.

Le & indique que cet argument est une référence, ce qui permet de laisser

plusieurs morceaux de votre code accéder à une même donnée sans avoir besoin

de copier ces données dans la mémoire plusieurs fois. Les références sont une

fonctionnalité complexe, et un des avantages majeurs de Rust est qu'il rend sûr

et simple l'utilisation des références. Il n'est pas nécessaire de trop

s'apesantir sur les références pour terminer ce programme.

Pour l'instant, tout ce que vous devez savoir est que comme les variables, les

références sont immuables par défaut.

D'où la nécessité d'écrire &mut supposition au lieu de &supposition pour la

rendre mutable. (Le chapitre 4 expliquera plus en détail les références.)

Gérer les erreurs potentielles avec le type Result

Nous avons encore du travail sur cette ligne de code. Même si nous allons rajouter une troisième ligne de code, elle ne fait partie que d'une seule ligne de code. Cette nouvelle partie rajoute cette méthode :

use std::io;

fn main() {

println!("Devinez le nombre !");

println!("Veuillez entrer un nombre.");

let mut supposition = String::new();

io::stdin()

.read_line(&mut supposition)

.expect("Échec de la lecture de l'entrée utilisateur");

println!("Votre nombre : {}", supposition);

}

Nous aurions pu écrire ce code de cette manière :

io::stdin().read_line(&mut supposition).expect("Échec de la lecture de l'entrée utilisateur");

Cependant, une longue ligne de code n'est pas toujours facile à lire, c'est donc

une bonne pratique de la diviser. Il est parfois utile d'ajouter une nouvelle

ligne et des espaces afin de désagréger les longues lignes lorsque vous

appelerez une méthode, comme ici avec la syntaxe .nom_de_la_methode().

Maintenant, voyons à quoi sert cette ligne.

Comme expliqué précédemment, read_line stocke dans la variable qu'on lui

passe en argument tout ce que l'utilisateur a saisi, mais cette fonction

retourne aussi une valeur − dans notre cas, de type

io::Result. Il existe plusieurs types nommés

Result dans la bibliothèque standard de Rust : un type générique

Result ainsi que des déclinaisons spécifiques à

des sous-modules, comme io::Result. Les types Result sont des

énumérations, aussi appelées enums, qui peuvent

avoir un certain nombre de valeurs prédéfinies que l'on appelle variantes.

Les énumérations sont souvent utilisées avec match, une structure

conditionelle qui facilite l'exécution d'un code différent en fonction de la

variante dans l'énumération au moment de son évaluation.

Le chapitre 6 explorera les énumérations plus en détail. La raison d'être du

type Result est de coder des informations pour la gestion des erreurs.

Les variantes de Result sont Ok et Err. La variante Ok signifie que

l'opération a fonctionné, et à l'intérieur de Ok se trouve la valeur générée

avec succès. La variante Err signifie que l'opération a échoué, et Err

contient les informations décrivant comment ou pourquoi l'opération a échoué.

Les valeurs du type Result, comme pour tous les types, ont des méthodes

qui leur sont associées. Par exemple, une instance de io::Result a une

méthode expect que vous pouvez utiliser. Si cette

instance de io::Result a pour valeur la variante Err, l'appel à expect

fera planter le programme et affichera le message que vous avez passé en

argument de expect. Si l'appel à read_line retourne une variante Err, ce

sera probablement dû à une erreur du système d'exploitation. Si en revanche

read_line a pour valeur la variante Ok, expect récupèrera le

contenu du Ok, qui est le résultat de l'opération, et vous le retournera afin

que vous puissiez l'utiliser. Dans notre exemple, ce résultat est le nombre

d'octets de la saisie utilisateur.

Si on n'appelle pas expect, le programme compilera, mais avec un

avertissement :

$ cargo build

Compiling jeu_du_plus_ou_du_moins v0.1.0 (file:///projects/jeu_du_plus_ou_du_moins)

warning: unused `Result` that must be used

--> src/main.rs:10:5

|

10 | io::stdin().read_line(&mut supposition);

| ^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^^

|

= note: `#[warn(unused_must_use)]` on by default

= note: this `Result` may be an `Err` variant, which should be handled

warning: `jeu_du_plus_ou_du_moins` (bin "jeu_du_plus_ou_du_moins") generated 1 warning

Finished dev [unoptimized + debuginfo] target(s) in 0.59s

Rust nous prévient que l'on ne fait rien du Result que nous fournit

read_line, et que par conséquent notre programme ne gère pas une erreur

potentielle.

La meilleure façon de masquer cet avertissement est de réellement écrire le

code permettant de gérer l'erreur, mais dans notre cas on a seulement besoin de

faire planter le programme si un problème survient, on utilise donc expect.

Nous verrons dans le chapitre 9 comment gérer

correctement les erreurs.

Afficher des valeurs grâce aux espaces réservés de println!

Mis à part l'accolade fermante, il ne nous reste plus qu'une seule ligne à étudier dans le code que nous avons pour l'instant :

use std::io;

fn main() {

println!("Devinez le nombre !");

println!("Veuillez entrer un nombre.");

let mut supposition = String::new();

io::stdin()

.read_line(&mut supposition)

.expect("Échec de la lecture de l'entrée utilisateur");

println!("Votre nombre : {}", supposition);

}

Cette ligne affiche la chaîne de caractères qui contient maintenant ce que

l'utilisateur a saisi. La paire d'accolades {} représente un espace réservé :

imaginez qu'il s'agit de pinces de crabes qui gardent la place d'une valeur.

Vous pouvez afficher plusieurs valeurs en utilisant des accolades : la première

paire d'accolades affichera la première valeur listée après la chaîne de

formatage, la deuxième paire d'accolades affichera la deuxième valeur, et ainsi

de suite. Pour afficher plusieurs valeurs en appelant println! une seule

fois, on ferait comme ceci :

#![allow(unused)] fn main() { let x = 5; let y = 10; println!("x = {} et y = {}", x, y); }

Ce code afficherait x = 5 et y = 10.

Test de la première partie

Pour tester notre début de programme, lançons-le à l'aide de la commande

cargo run :

$ cargo run

Compiling jeu_du_plus_ou_du_moins v0.1.0 (file:///projects/jeu_du_plus_ou_du_moins)

Finished dev [unoptimized + debuginfo] target(s) in 6.44s

Running `target/debug/jeu_du_plus_ou_du_moins`

Devinez le nombre !

Veuillez entrer un nombre.

6

Votre nombre : 6

À ce stade, la première partie de notre programme est terminée : nous avons récupéré la saisie du clavier et nous l'affichons à l'écran.

Générer le nombre secret

Maintenant, il nous faut générer un nombre secret que notre joueur va devoir

deviner. Ce nombre devra être différent à chaque fois pour qu'on puisse

s'amuser à y jouer plusieurs fois. Nous allons tirer au sort un nombre compris

entre 1 et 100 pour que le jeu ne soit pas trop difficile. Rust n'embarque pas

pour l'instant de fonctionnalité de génération de nombres aléatoires dans sa

bibliothèque standard. Cependant, l'équipe de Rust propose une

crate rand qui offre la possibilité de le faire.

Étendre les fonctionnalités de Rust avec une crate

Souvenez-vous, une crate est un ensemble de fichiers de code source Rust. Le

projet sur lequel nous travaillons est une crate binaire, qui est un programme

exécutable. La crate rand est une crate de bibliothèque, qui contient du

code qui peut être utilisé dans d'autres programmes, et qui ne peut pas être

exécuté tout seul.

La coordination des crates externes est un domaine dans lequel Cargo excelle.

Avant d'écrire le code qui utilisera rand, il nous faut éditer le fichier

Cargo.toml pour y spécifier rand en tant que dépendance. Ouvrez donc

maintenant ce fichier et ajoutez la ligne suivante à la fin, en dessous de

l'en-tête de section [dependencies] que Cargo a créé pour vous. Assurez-vous

de spécifier rand exactement comme dans le bout de code suivant, avec ce

numéro de version, ou sinon les exemples de code de ce tutoriel pourraient ne

pas fonctionner.

Fichier : Cargo.toml

rand = "0.8.3"

Dans le fichier Cargo.toml, tout ce qui suit une en-tête fait partie de cette

section, et ce jusqu'à ce qu'une autre section débute. Dans [dependencies],

vous indiquez à Cargo de quelles crates externes votre

projet dépend, et de quelle version de ces crates vous avez besoin.

Dans notre cas, on ajoute comme dépendance la crate rand avec la version

sémantique 0.8.3. Cargo arrive à interpréter le

versionnage sémantique (aussi appelé SemVer), qui

est une convention d'écriture de numéros de version. En réalité, 0.8.3 est

une abréviation pour ^0.8.3, ce qui signifie “toute version ultérieure ou

égale à 0.8.3 mais strictement antérieure à 0.9.0”. Cargo considère que ces

versions ont des API publiques compatibles avec la version 0.8.3, et cette

indication garantit que vous obtiendrez la dernière version de correction qui

compilera encore avec le code de ce chapitre. Il n'est pas garanti que les

versions 0.9.0 et ultérieures aient la même API que celle utilisée dans les

exemples suivants.

Maintenant, sans apporter le moindre changement au code, lançons une compilation du projet, comme dans l'encart 2-2 :

$ cargo build

Updating crates.io index

Downloaded rand v0.8.3

Downloaded libc v0.2.86

Downloaded getrandom v0.2.2

Downloaded cfg-if v1.0.0

Downloaded ppv-lite86 v0.2.10

Downloaded rand_chacha v0.3.0

Downloaded rand_core v0.6.2

Compiling rand_core v0.6.2

Compiling libc v0.2.86

Compiling getrandom v0.2.2

Compiling cfg-if v1.0.0

Compiling ppv-lite86 v0.2.10

Compiling rand_chacha v0.3.0

Compiling rand v0.8.3

Compiling jeu_du_plus_ou_du_moins v0.1.0 (file:///projects/jeu_du_plus_ou_du_moins)

Finished dev [unoptimized + debuginfo] target(s) in 2.53s

Encart 2-2 : Résultat du lancement de cargo build après

avoir ajouté la crate rand comme dépendance

Il est possible que vous ne voyiez pas exactement les mêmes numéros de version, (mais ils seront compatibles avec votre code, grâce au versionnage sémantique !), différentes lignes (en fonction de votre système d'exploitation), et les lignes ne seront pas forcément affichées dans le même ordre.

Lorsque nous ajoutons une dépendance externe, Cargo récupère les dernières versions de tout ce dont cette dépendance a besoin depuis le registre, qui est une copie des données de Crates.io. Crates.io est là où les développeurs de l'écosystème Rust publient leurs projets open source afin de les rendre disponibles aux autres.

Une fois le registre mis à jour, Cargo lit la section [dependencies] et se

charge de télécharger les crates qui y sont listés que vous n'avez pas encore

téléchargé. Dans notre cas, bien que nous n'ayons spécifié qu'une seule

dépendance, rand, Cargo a aussi téléchargé d'autres crates dont dépend

rand pour fonctionner. Une fois le téléchargement terminé des crates, Rust

les compile, puis compile notre projet avec les dépendances disponibles.

Si vous relancez tout de suite cargo build sans changer quoi que ce soit, vous

n'obtiendrez rien d'autre que la ligne Finished. Cargo sait qu'il a déjà

téléchargé et compilé les dépendances, et que vous n'avez rien changé dans votre

fichier Cargo.toml. Cargo sait aussi que vous n'avez rien changé dans votre

code, donc il ne le recompile pas non plus. Étant donné qu'il n'a rien à faire,

Cargo se termine tout simplement.

Si vous ouvrez le fichier src/main.rs, faites un changement très simple, enregistrez le fichier, et relancez la compilation, vous verrez s'afficher uniquement deux lignes :

$ cargo build

Compiling jeu_du_plus_ou_du_moins v0.1.0 (file:///projects/jeu_du_plus_ou_du_moins)

Finished dev [unoptimized + debuginfo] target(s) in 2.53 secs

Ces lignes nous informent que Cargo a recompilé uniquement à cause de notre petit changement dans le fichier src/main.rs. Les dépendances n'ayant pas changé, Cargo sait qu'il peut simplement réutiliser ce qu'il a déjà téléchargé et compilé précédemment.

Assurer la reproductibilité des compilations avec le fichier Cargo.lock

Cargo embarque une fonctionnalité qui garantie que vous pouvez recompiler le

même artéfact à chaque fois que vous ou quelqu'un d'autre compile votre code :

Cargo va utiliser uniquement les versions de dépendances que vous avez

utilisées jusqu'à ce que vous indiquiez le contraire.

Par exemple, immaginons que la semaine prochaine, la version 0.8.4 de la

crate rand est publiée, et qu'elle apporte une correction importante, mais

aussi qu'elle produit une régression qui va casser votre code. Pour éviter cela,

Rust crée le fichier Cargo.lock la première fois que vous utilisez

cargo build, donc nous l'avons désormais dans le dossier

jeu_du_plus_ou_du_moins.

Quand vous compilez un projet pour la

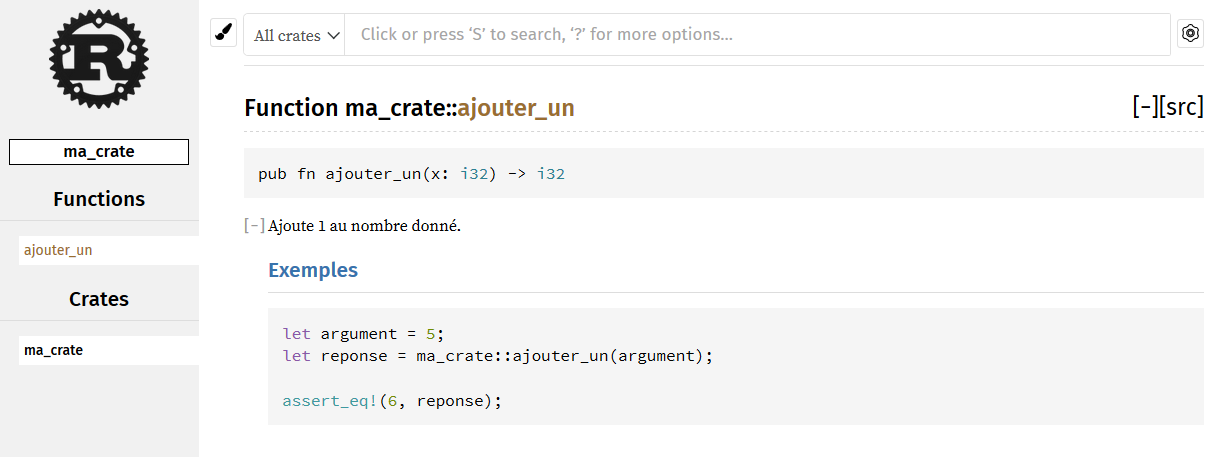

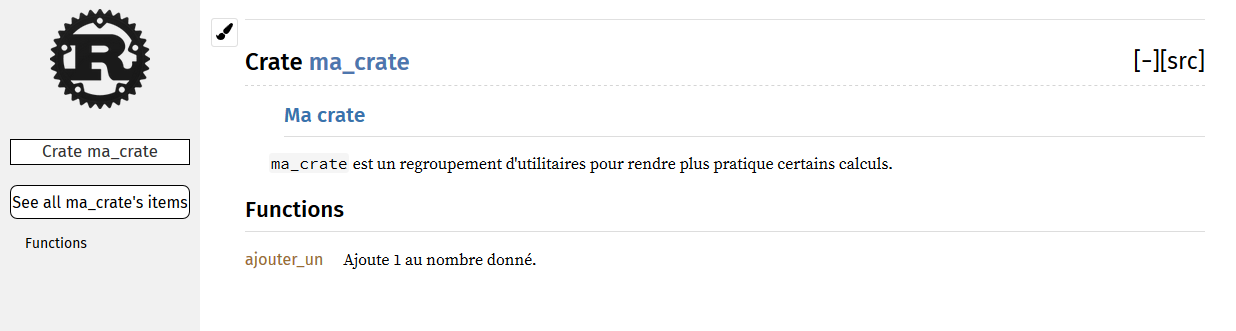

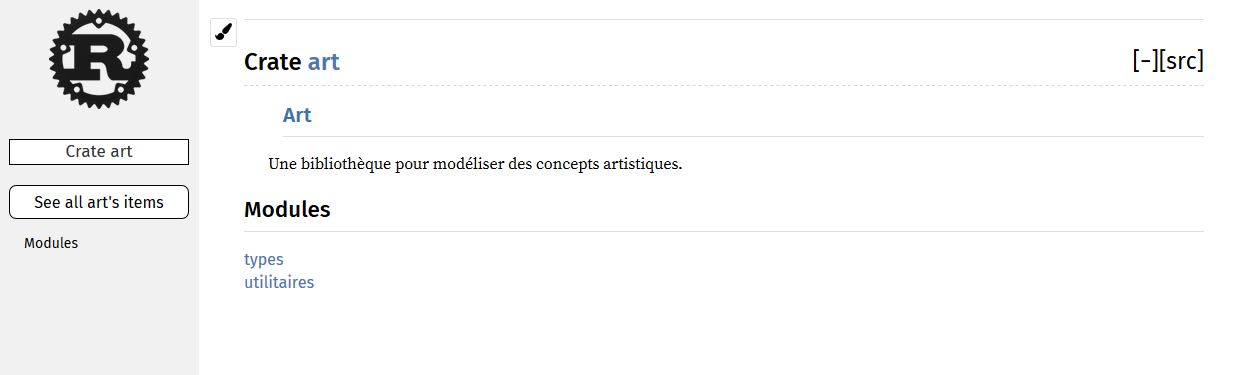

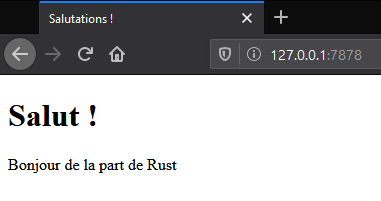

première fois, Cargo détermine toutes les versions de dépendances qui